Wenn beim Streaming das Video stockt oder die 3D-Simulation im Metaverse Ewigkeiten benötigt, um zu laden, sorgt das bei den Anwenderinnen und Anwendern für Unmut. Moderne KI-Verfahren sollen künftig den Verkehr im Internet so verteilen, dass sich möglichst niemand ausgebremst fühlt. An der Universität Augsburg wurde jetzt ein System vorgestellt, das die Qualität sehr vieler Datenströme in Echtzeit bewerten kann. Das gilt als eine Grundvoraussetzung, um durch ein besseres Daten-Management die Zufriedenheit im Netz zu verbessern. Die Ergebnisse erscheinen in der Fachzeitschrift IEEE Transactions on Network and Service Management.

Online-Spiele, Video-Streams, Besuche in den virtuellen Welten des Metaverse: Immer mehr Anwendungen sind auf eine gut funktionierende Internetverbindung angewiesen. Was „gut funktionierend“ genau bedeutet, ist aber von Fall zu Fall unterschiedlich: Gamer möchten die Aktionen ihrer Gegner mit möglichst geringer Verzögerung mitbekommen, um noch reagieren zu können. Wer sich einen Film anschaut, stört sich vor allem daran, wenn das Bild plötzlich einfriert und dann erst nach ein paar Sekunden weiterläuft – nötig ist also eine möglichst konstante Datenrate. Und ein großer Download soll möglichst schnell und gleichzeitig fehlerfrei erfolgen. Die Dienste müssen also im Netz unterschiedlich behandelt werden, damit die jeweiligen Nutzer zufrieden sind.

Verschlüsselte Datenverbindungen erschweren es, die Nutzer zufriedenzustellen

„Viele Datenverbindungen erfolgen heute aber verschlüsselt“, erklärt Prof. Dr. Michael Seufert, Inhaber des Lehrstuhls für Vernetzte Eingebettete Systeme und Kommunikationssysteme der Universität Augsburg. „Das heißt, es lässt sich nicht einfach erkennen, ob ein Datenpaket zu einem Video, zu einer Webseite oder zu einem Download gehört. Das erschwert es, die Datenströme je nach Nutzung angepasst und gerecht zu verteilen.“

Seufert leitet eine sogenannte Emmy-Noether-Forschungsgruppe, die dieses Problem lösen möchte. Die Idee hinter dem von der Deutschen Forschungsgemeinschaft (DFG) mit 1,9 Millionen Euro geförderten Projekt: KI-Algorithmen sollen die verschickten Datenpakete analysieren und anhand bestimmter Gemeinsamkeiten erkennen, zu welcher Kategorie von Anwendungen sie gehören. Außerdem sollen sie abschätzen, welche Qualität diese Anwendung momentan für den Nutzer hat – ob also etwa ein Videostream spürbar ruckelt oder ohne Störung abspielt.

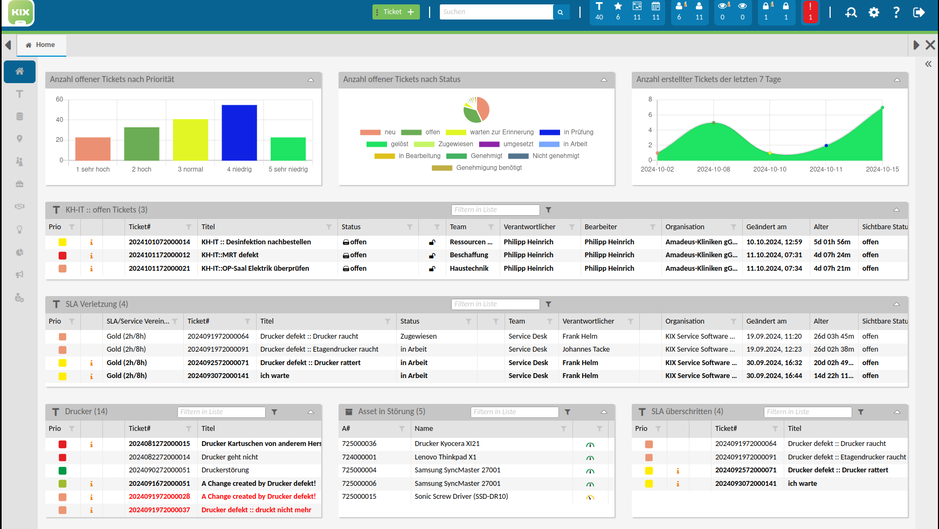

Auf diesem Weg sind die Forschenden nun einen großen Schritt vorwärtsgekommen: „Wir haben eine Methode entwickelt, bei der ein Switch, der ein sehr hohes Aufkommen an Internet-Daten weiterleitet, zusätzlich in Echtzeit deren Qualität bewerten kann“, sagt der Informatiker. „Wir sprechen hier von mehreren Terabit pro Sekunde – das sind Größenordnungen, wie sie etwa bei 250.000 gleichzeitigen Videostreams anfallen würden.“ Seine Arbeitsgruppe nutzte dazu Verfahren aus dem Bereich des maschinellen Lernens. Die Algorithmen werden dabei mit einer Vielzahl von Datenpaketen gefüttert. Im Laufe dieses Trainings lernen sie, die verschiedenen Arten von Daten anhand spezifischer Charakteristika zu erkennen. „Wir erzeugen dazu im Labor automatisiert verschiedene Datenströme - zum Beispiel, indem wir Smartphones per Mobilfunk ein Video aufrufen lassen, mit verschiedenen PCs per DSL oder Glasfaser eine Reihe von Downloads starten oder auch andere Dienste nutzen“, sagt er. „Der generierte Datenverkehr wird aufgezeichnet und für das Training der KI-Algorithmen genutzt.“

Wieviel Verzögerung ist tolerierbar?

Die jetzt veröffentlichte Methode ist ein erster Schritt, um die Zufriedenheit der Anwenderinnen und Anwender mit den von ihnen genutzten Internetdiensten zu verbessern. „Wir sprechen in diesem Zusammenhang auch von Quality of Experience, abgekürzt QoE“, erklärt Seufert. „Wenn etwa ein Videostream ruckelt, mindert das die QoE deutlich. Wenn es ein paar Sekundenbruchteile länger dauert, eine Webseite aufzurufen, ist das dagegen weniger störend.“

Seine Arbeitsgruppe möchte auch herausfinden, welche Verzögerungen Nutzerinnen und Nutzer tolerieren, ohne dass ihre Zufriedenheit mit der Internetverbindung spürbar leidet. „Dazu führen wir Experimente mit Versuchspersonen durch, in denen wir zum Beispiel bestimmte Dienste gezielt ausbremsen“, sagt er. Die Ergebnisse dieser Studien geben dann Aufschluss darüber, wie die unterschiedlichen Anforderungen der Datenströme am besten und am fairsten erfüllt werden können. „Da die Datenmengen im Internet so stark wachsen, werden immer wieder Situationen auftauchen, in denen es zu Engpässen kommt“, erklärt Seufert. „Wir wollen mit unserer Forschung erreichen, diese Engpässe so geschickt zu managen, dass sie möglichst wenige Menschen stören.“

Originalpublikation:

Michael Seufert, Katharina Dietz, Nikolas Wehner, Stefan Geißler, Joshua Schüler, Manuel Wolz, Andreas Hotho, Pedro Casas, Tobias Hoßfeld, Anja Feldmann: "Marina: Realizing ML-driven Real-time Network Traffic Monitoring at Terabit Scale", IEEE Transactions on Network and Service Management, 2024. https://doi.org/10.1109/TNSM.2024.3382393

Foto: Prof. Dr. Michael Seufert leitet in Augsburg eine Emmy-Noether-Forschungsgruppe, die ein KI-System entwickelt, dass die Internet-Qualität verbessern soll. Quelle: privat/Uni Augsburg

Quelle: Universität Augsburg